Dans un monde où l’intelligence artificielle évolue à un rythme effréné, une nouvelle norme émerge pour simplifier la connexion des modèles d’IA aux sources de données externes. Le Model Context Protocol (MCP), développé par Anthropic, est en train de devenir le ‘USB-C de l’IA’, unissant même les rivaux les plus féroces autour d’une vision commune.

Une Collaboration Inattendue

OpenAI et Anthropic, deux géants souvent en concurrence dans le domaine de l’IA, ont trouvé un terrain d’entente grâce au MCP. Cette norme ouverte, lancée en novembre 2024, permet aux modèles d’IA d’interagir avec des sources de données externes sans nécessiter d’intégrations spécifiques pour chaque service.

MCP : Une Analogie avec USB-C

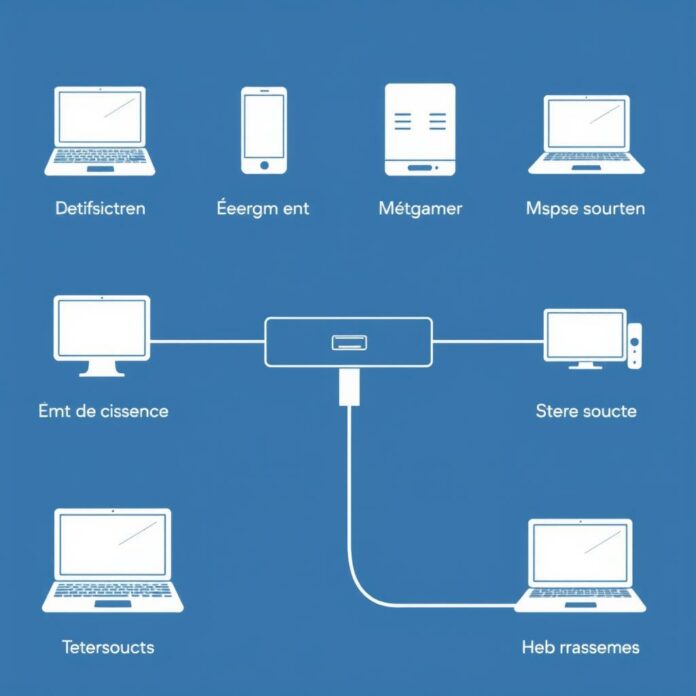

Anthropic compare le MCP à un port USB-C pour les applications d’IA. Bien que l’analogie ne soit pas parfaite, elle illustre bien l’objectif du MCP : standardiser la manière dont les modèles d’IA se connectent à l’écosystème informationnel qui les entoure.

Un Soutien Croissant

Le MCP a rapidement gagné le soutien de plusieurs entreprises technologiques, dont Microsoft et OpenAI. Sam Altman, CEO d’OpenAI, a publiquement exprimé son enthousiasme pour cette initiative, soulignant son potentiel à transformer l’industrie.

Comprendre le ‘Contexte’ en IA

Le ‘contexte’ dans le domaine de l’IA fait référence à toutes les données fournies par l’utilisateur qui guident le modèle pour produire une réponse. Avant le MCP, l’accès à des sources de données externes était souvent complexe et nécessitait des intégrations personnalisées pour chaque service.

Comment Fonctionne le MCP ?

Le MCP utilise un modèle client-serveur pour connecter les modèles d’IA aux sources de données. Cette approche standardisée permet une interaction fluide et efficace, ouvrant la porte à une multitude d’applications potentielles, de la gestion des commandes à l’analyse de données en temps réel.

Un Projet en Évolution

Bien que prometteur, le MCP est encore à un stade précoce de développement. Son adoption généralisée pourrait néanmoins réduire la dépendance aux fournisseurs et favoriser l’émergence de modèles d’IA plus petits et plus efficaces.